User-agent: *

Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /wp-content/

Sitemap: http://blog.kongxz.com/sitemap.xml.gz

User-agent: Baiduspider

Disallow: /意思显而易见了:百毒一律禁止。

这个robots.txt是我搬到kongxz.com这个域名(今年7月4日)时就有的。

而我原来用kmxzblog.cn时也一直用PHP进行判断:若user-agent中含有"baidu"就直接wp_die();

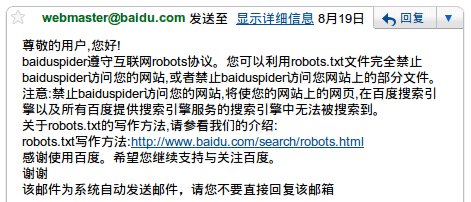

8月中旬我向百度投诉,收到了这样的自动回复:

操,真敢说。我一直没管这事。

今天(8月29日)心血来潮到百度上又搜了一遍:

结论

1、本来百度无视robots.txt就是公认的,百度还说什么“baiduspider遵守互联网robots协议”……真是没法形容。

2、原来针对User-Agent判断,对含"baidu"的user-agent输出错误页,但那时候内容还是被正常收录了,说明很可能百度的搜索内容不完全是自己的爬虫收录的。

评论